AI är en leveranskedja, inte en trollstav: vad NIS2 innebär för AI-styrning

av Ilpo Elfving / Econ VD

av Ilpo Elfving / Econ VD

En utexaminerad AI-ingenjör levererar mat för Wolt under hot om utvisning medan 50-70% av internationella studenter avbryter sina studier inom specialområden. Hur Integrator-PM-modellen och intern AI kan lösa Finlands talangintegrationskris.

Read moreFinlands cybersäkerhetslag (124/2025) ålägger ledningen inom livsmedelsindustrin ett personligt ansvar för cybersäkerhet. Kritiska tidsfrister, sanktionsavgifter på upp till 7 miljoner euro och konkreta åtgärder för att uppnå efterlevnad.

Read moreJag fick nyligen en förstahandserfarenhet där ett ledande AI-företag inte kunde lösa en enkel faktureringstvist efter sju veckor (fortfarande pågående när detta skrivs) av AI-assisterad support. E-post dirigerades tyst till chattbottar, ärenden splittrades över parallella trådar med endast en del av kontexten och historiken, dubbletter skapades och stängdes utan meddelande, kontext förlorades efter eskalering till en mänsklig representant, och processen återgick flera gånger till AI-loopar efter att en människa hade fattat beslut och lovat återbetalning. Detta avslöjar något väsentligt om hur AI faktiskt fungerar i praktiken.

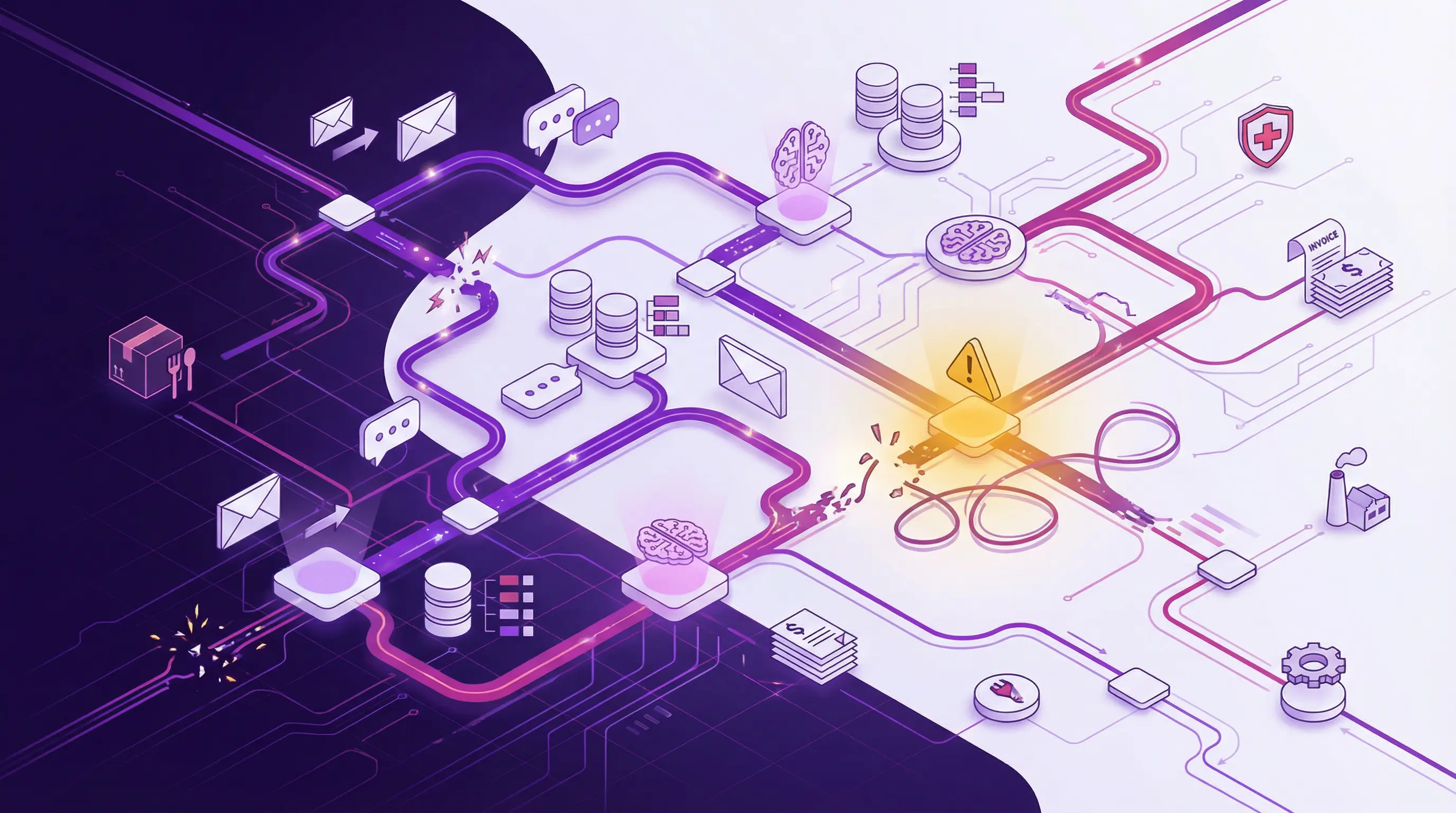

Det här är inte ett isolerat leverantörsproblem. Det visar vad som händer när AI-driven support behandlas som ett bekvämt automatiseringslager istället för vad det faktiskt är: en digital leveranskedja bestående av chatt, e-postsystem, dirigeringslogik, språkmodeller, tillägg och backoffice-integrationer – var och en med olika ägare, loggar och fellägen.

För ledare inom livsmedels-, handels- och hälsovårdssektorn som nu omfattas av Finlands cybersäkerhetslag (124/2025) har detta direkt betydelse. Om AI berör din produktionsplanering, leveranslöften, kylkedjeövervakning eller patientdokumentation är du juridiskt ansvarig för styrningen av hela kedjan. Inte bara "AI-delen".

Paragraf 10 i Finlands cybersäkerhetslag kräver att ledningen upprätthåller tillräcklig kompetens inom cybersäkerhetsriskhantering och personligen godkänner säkerhetsåtgärder. Denna skyldighet omfattar AI-system som berör väsentliga verksamheter. Att delegera AI-styrning helt till IT-avdelningen är inte längre juridiskt försvarbart.

Cybersäkerhetslagen (124/2025) implementerar EU:s NIS2-direktiv i Finland. Dess kärnkrav är tydliga:

Artikel 21 i NIS2 inkluderar uttryckligen leveranskedjans säkerhet som ett obligatoriskt riskhanteringsområde. AI-system – oavsett om de är inbyggda i ditt affärssystem, driver kundtjänst eller automatiserar klinisk dokumentation – är en del av den leveranskedjan.

Anledningen till att AI-styrning känns svårgreppbart är att "AI" aldrig är en enda sak. Varje AI-aktiverad tjänst är en stack av komponenter och leverantörer:

E-postadresser, chattgränssnitt, API-ändpunkter, mobilappar – var och en med dirigeringsregler som tyst kan omdirigera meddelanden.

Ärendehanteringssystem, arbetsflödesautomation, agentramverk – bestämmer vart förfrågningar går och vilken kontext som följer med.

Språkmodeller som genererar svar, klassificeringsmodeller som dirigerar ärenden, prediktionsmodeller som föreslår åtgärder – var och en med olika leverantörer, versioner och beteenden.

Kopplingar till affärssystem, lagerhantering, patientjournaler, CRM, fakturering, logistik – där AI-utdata blir verkliga handlingar.

Där prompter, kontext och utdata lagras – med implikationer för datalagring, lagringstider och regelefterlevnad.

När något går fel – kontext försvinner, beslut fattas på ofullständig information, eskaleringar når aldrig människor – ligger felet sällan i "AI:n". Det ligger i fogarna mellan dessa lager.

NIS2 bryr sig inte om felet orsakas av en skadlig handling eller om det börjar i en språkmodell, ett tillägg eller en e-postrouter. Direktivet tittar på påverkan på dina väsentliga tjänster och om du hanterade riskerna i hela den digitala leveranskedjan.

Det abstrakta blir konkret när du kartlägger AI-beröringspunkter i faktiska verksamheter.

AI analyserar temperatursensordata för att förutsäga försämring eller utlösa larm. Om modellen felklassificerar en kritisk avvikelse äventyras produktsäkerheten.

AI förutser ordervolymer för produktionsplanering. Felaktiga prognoser sprider sig som överlager, svinn eller bristsituationer genom hela leveranskedjan.

AI-assisterad GDSN-inmatning och produktbeskrivningar. Fel sprids till detaljhandlare, efterlevnadssystem och konsumentmärkningar.

AI dirigerar och besvarar leverantörsmeddelanden. Förlorad kontext eller feldirigerade meddelanden kan störa inköpstidplaner.

AI planerar leveransrutter baserat på realtidsdata. Modellfel eller inaktuell data kan försena tidskritiska leveranser.

AI-assisterad klassificering och deklarationsförberedelse. Felklassificering skapar efterlevnadsrisker och gränsförseningar.

AI-chattbottar hanterar orderstatus, leveranstider och avvikelser. Om eskaleringsvägar bryts förblir kundproblem olösta.

AI justerar priser baserat på efterfrågan, lager och konkurrens. Okontrollerade modeller kan urholka marginaler eller kundförtroende.

AI transkriberar mottagningar eller sammanfattar patienthistorik. Fel i medicinsk kontext kan påverka vårdbeslut.

AI prioriterar patientförfrågningar och schemalägger besök. Feldirigerade brådskande fall skapar patientsäkerhetsrisker.

AI-assisterad receptkontroll eller dosberäkningar. Modellfel i detta sammanhang har direkta säkerhetskonsekvenser.

AI hanterar bokningspåminnelser, uppföljningar och frågor. Förlorade meddelanden eller felaktig information urholkar förtroende och vårdkontinuitet.

Vi inför AI endast där det ger mätbart och kontrollerat värde. Inte för bekvämlighet eller nyhetsvärde. Styrningsbristerna som uppstår även hos ledande AI-leverantörer illustrerar exakt varför: okontrollerad AI skapar okontrollerad risk. Om du inte kan kartlägga leveranskedjan bakom en AI-funktion kan du inte hantera den. Och enligt NIS2 är du ansvarig för att hantera den.

När AI-drivna processer havererar är grundorsakerna vanligtvis inte sofistikerade. De är vardagliga styrningsbrister:

Osynligt kanalbyte. Användarmeddelanden dirigeras tyst från e-post till chatt till AI utan meddelande. Ur ett styrningsperspektiv innebär detta förlust av transparens och spårbarhet.

Fragmenterad kontext. Modelluppdateringar, plattformsändringar eller systemintegrationer som bryter kontinuiteten. Senare mänskliga handläggare eller efterföljande AI-interaktioner saknar fullständig historik.

Ingen tydlig ägare för hela kedjan. E-post, chatt, AI och backoffice-system fungerar som separata silos. Ingen är ansvarig för helhetslösning och datakonsistens.

Klyfta mellan policy och verklighet. Faktureringssystemet accepterade en avbokning; AI:n insisterar på en annan process. Affärssystemet visar lagersaldo; AI-chattbotten påstår motsatsen.

Inget av detta kräver illvillig AI. Det är vad som händer när man behandlar AI som ett verktyg man bara kopplar in och glömmer att man har utvidgat sin digitala leveranskedja med fler integrationspunkter, fler rörliga delar och fler sätt att förlora kontext och ägarskap.

Chefer behöver inte ytterligare ett 40-sidigt ramverk. De behöver en lista över icke-förhandlingsbara punkter som kopplar AI-styrning till befintliga NIS2-skyldigheter.

Fatta ett uttryckligt styrelsebeslut: AI-system som berör väsentliga verksamheter omfattas av NIS2-riskhantering. Dokumentera beslutet.

För varje kritiskt AI-användningsfall, rita ett diagram: kommunikationskanaler, orkestrering/dirigering, modellleverantörer, tilläggskopplingar, datalager och lagringsplatser. En sida per användningsfall.

Utse en processägare för varje AI-aktiverat flöde, inte "AI-teamet". Ägaren ansvarar för resultat oavsett hur många verktyg som är sammankopplade.

Kräv att AI-lösningar loggar kanalbyten, bevarar ärendehistorik över uppdateringar och ger människor fullständig kontext. Förbjud "slutna AI-loopar" utan eskaleringsväg.

Lägg till AI- och molnmodellleverantörer i leverantörsriskprogrammet. Täck dataanvändning, lagringsplatser, underbiträden, incidentrapportering och support-SLA:er i avtal.

Bädda in AI i ditt ledningssystem för informationssäkerhet (ISMS): åtkomstkontroll, ändringshantering, säker utveckling, verksamhetskontinuitet. Behandla kritisk AI-konfiguration som kod: granska, testa, dokumentera.

Om AI berör HACCP-närliggande system, kylkedjeövervakning, spårbarhet eller GDSN-produktdata, inkludera den i din cybersäkerhetsriskhantering. Livsmedelsverket övervakar NIS2-efterlevnad för livsmedelsaktörer. Anpassa AI-styrningen efter deras förväntningar.

AI i patientflöden, klinisk dokumentation eller läkemedelshantering medför både NIS2- och sektorspecifika regulatoriska krav. Säkerställ att AI-styrningen integreras med befintliga ramverk för patientsäkerhet och dataskydd.

AI i tullklassificering, ruttoptimering eller B2B-kommunikation påverkar handelsefterlevnad och kundrelationer. Kartlägg AI-beroenden i EDI/Peppol-, lagerhantering- och transporthanteringssystem som del av bedömningen av den digitala leveranskedjan.

Använd denna checklista för att bedöma din nuvarande AI-styrning och identifiera brister.

Besluta formellt att AI-system kopplade till väsentliga tjänster omfattas av NIS2-riskhantering. Dokumentera beslutet.

Lista alla AI/ML-verktyg i produktion eller piloter, inklusive externa SaaS-tjänster med inbyggd AI och interna experiment.

För varje kritiskt AI-användningsfall, rita diagram över kanaler, orkestrering, modeller, tillägg och datalagringsplatser.

Varje AI-aktiverad process har en namngiven ägare ansvarig för resultat och risk – inte bara "AI-teamet".

Definiera hur ärenden rör sig mellan AI och människor. Kräv fullständig historiköverföring. Förbjud slutna AI-loopar.

AI- och molnmodellleverantörer inkluderade i leverantörsriskprogrammet med dokumenterade utvärderingar.

AI är redan en del av din digitala leveranskedja. Den enda frågan är om du styr den medvetet eller upptäcker bristerna under en incident.

Finlands cybersäkerhetslag är nu i kraft. Ledningen är personligt ansvarig. Leveranskedjans säkerhet – inklusive AI-leverantörer – omfattas uttryckligen.

Den goda nyheten: om du redan har implementerat NIS2-riskhantering för dina traditionella IT- och OT-system är det möjligt att utvidga ramverket till AI. Samma principer gäller: kartlägg beroenden, utse ägare, hantera leverantörer, integrera kontroller, förbered för incidenter.

Om du lyckas med detta blir AI en styrd förmåga som stödjer resiliens och efterlevnad. Om du ignorerar det riskerar du att hamna – tillsammans med dina kunder – i en okontrollerad AI-loop där ingen äger resultatet.

Och till skillnad från en faktureringstvist blir kostnaden för den loopen inom livsmedelssäkerhet, patientvård eller handelsefterlevnad inte trivial.

Källor:

Definiera AI-specifika incidentscenarier: dataläckage via AI, osäkra automatiserade beslut, processavbrott. Inkludera isoleringsprocedurer och bevisbevarande.

Ledningen måste förstå: språkmodeller förutsäger ord, inte sanning; kontextfönster är begränsade; dirigeringslager kan tyst tappa information. Detta uppfyller kravet på "tillräcklig förtrogenhet".

AI-avtal täcker begränsningar för dataanvändning, incidentrapportering, myndighetssamarbete och funktionskontroll.

AI inbäddad i befintlig åtkomstkontroll, ändringshantering, säker utveckling samt kontinuitets- och återhämtningsplaner.

Kritiska AI-system loggar prompter, kontext, verktygsanrop och utdata. Avvikelseövervakning konfigurerad.

Incidenthanteringsplaner inkluderar AI-specifika scenarier, isoleringsprocedurer och bevisbevarande.

Ledningen utbildad i AI-beteende, begränsningar och risker för att uppfylla kravet på "tillräcklig förtrogenhet".

Praktisk utbildning i "säker AI-användning på jobbet" för personal som arbetar med AI-aktiverade system.

AI-styrning anpassad till sektorspecifika förväntningar (Livsmedelsverket, Valvira osv.).

AI-arkitekturer, riskbedömningar, kontroller och godkännanden dokumenterade för att påvisa efterlevnad.